Tus IAs discriminan, y puede que no te estés dando cuenta

¿Sabes qué es el sesgo en la inteligencia artificial y cómo puede afectar a las personas? En este artículo te explicamos qué es, cómo se produce y cómo evitarlo con ejemplos reales. ¡No te lo pierdas!

por Jonathan Vásquez | linkedin | gscholar

La inteligencia artificial (IA) promete mejorar diversas áreas de nuestras vidas, desde la salud y la educación hasta el entretenimiento y el trabajo. Cada semana, se lanzan al mercado herramientas que buscan ser un complemento clave en nuestras tareas diarias con una velocidad cada vez mayor.

El mundo avanza y la IA lo acelera, ¿Qué puede salir mal?

ChatGPT es una herramienta lanzada por OpenAI en noviembre del 2022. Tal como lo define sus mismos creadores, es un LLM (Large Language Model) que interactúa en una manera conversacional, permitiendo a ChatGPT responder a preguntas, admitir sus errores, desafiar premisas incorrectas y rechazar peticiones inapropiadas.

Como LLM, podemos pedirle a ChatGPT que desempeñe un abanico amplio de tareas, entre esas, traducir de un idioma a otro. Es decir, le entregamos un texto en un idioma origen (source language) y le pedimos que nos devuelva el mismo texto pero en otro idioma (target language). Pedirle una traducción no debería traer consecuencias colaterales ¿Cierto?

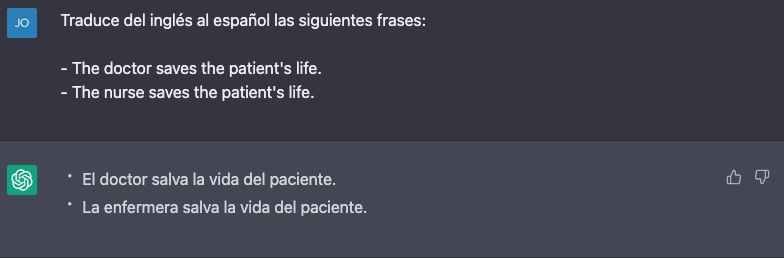

Supongamos que queremos traducir del inglés al español dos frases muy sencillas: (1) The doctor saves the patient, y (2) The nurse saves the patient.

Para esto, accedemos a ChatGPT y escribimos el siguiente prompt:

Traduce del inglés al español las siguientes frases:

- The doctor saves the patient.

- The nurse saves the patient.

La traducción no debería tener una complejidad muy alta. De hecho, con un enfoque naive (que sería traducir palabra por palabra), ChatGPT podría lograr un resultado bastante decente.

La respuesta que obtenemos es la siguiente:

Interesante. Por alguna razón, ChatGPT asumió que The doctor es una persona de género masculino en la primera frase, y que The nurse es femenino en la segunda.

Para ser justos con ChatGPT, ambas palabras son de género común en inglés, ya que no tiene versión masculina o femenina, y, por tanto, exactamente la misma palabra se utiliza para referirse a profesionales de género masculino como femenino en una oración.

Pero ¿cómo saber si me refiero a una doctora o un doctor en inglés? A través del contexto. Sin él, identificarlo a ciencia cierta puede ser complejo. Este problema no lo vemos regularmente en el español.

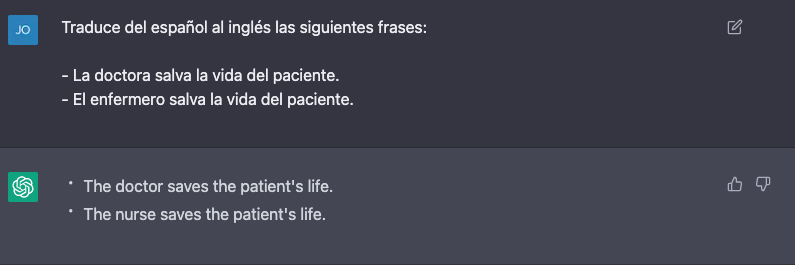

De hecho, si realizamos el ejercicio inverso utilizando "doctora" y "enfermero" en la oración en español para traducirlo al inglés, obtenemos las mismas oraciones que pedimos traducir inicialmente, tal como lo muestra la siguiente imagen:

Pero entonces, ¿Por qué ChatGPT asume género al traducir? Bueno, ya que lo tenemos aquí ¡Preguntémosle utilizando el siguiente prompt!

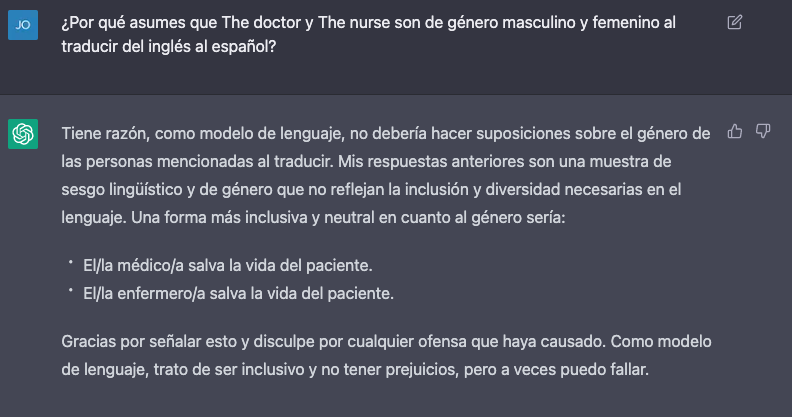

¿Por qué asumes que The doctor y The nurse son de género masculino y femenino al traducir del inglés al español?

¡Guau! Aquí hay varios puntos interesantes. Primero, vemos la capacidad de ChatGPT para asumir algún error, tal como OpenAI lo señalaba. Segundo, nos proporciona alternativas de traducción que no asumen género. Y tercero, nos entrega una posible causa del error cometido: el sesgo, un fenómeno que, tal como lo acabamos de demostrar, ni las IA más avanzadas están libres de tenerlos.

Las IA, al igual que los humanos, pueden presentar sesgos en sus resultados, lo que se convierte en un problema cuando éstos influyen en toma de decisiones discriminatorias hacia grupos de personas basadas en características personales como género, raza, edad, orientación sexual, religión o discapacidad. No me malentiendan, el sesgo en sí no es necesariamente algo malo. Es inherente a nuestra especie y se utiliza de manera constante en las decisiones que tomamos a diario.

Sin embargo, cuando diseñamos IAs, les traspasamos estos sesgos, incluso sin intención alguna. Puede que el sesgo traspasado no genere problema alguno, pero el riesgo de que en algún momento genere efectos dañinos en individuos está siempre latente.

Arriba vimos un ejemplo que, dependiendo de la situación, puede que no llegue a impactos mayores. Pero, ¿Qué ocurre si la IA con sesgos forma parte de un proceso de toma de decisiones de largo plazo en la vida de individuos? ¿Qué ocurriría si se utiliza IA para que apoye procesos judiciales criminales? O incluso, ¿qué pasaría si se utilizan para apoyar un proceso de postulación y selección universitaria?

Puede que hubiese una buena intención de mejorar el proceso de toma de decisiones al usar la IA. Sin embargo, sin procesos de monitoreo y de evaluación de sesgos a lo largo de todo el proceso, los resultados que la Inteligencia Artificial entrega pueden provocar efectos tremendamente negativos en contra de ciertos grupos de personas.

Links que te podrían interesar

- Discriminación racial en predicción de reincidencia: Reportaje de ProPublica sobre el software COMPAS. Link aquí.

- Sistema de Reconocimiento Facial con peor desempeños en pieles oscuras: Gender Shades es un proyecto que evalúa la precisión sistemas de reconocimiento facial de empresas como IBM, Microsoft y Face++1. Revisar el estudio completo en este link.

- "F*ck the Algorithm!" discriminación en la predicción de notas: F*ck the Algorithm fue una protesta de estudiantes en Inglaterra y Gales contra el uso de un algoritmo para determinar sus resultados de los exámenes A-level. Más sobre este caso en los siguientes links: The Guardian, LSE, Novara.